pg电子麻将胡了入口下载 一文读懂机器学习大杀器XGBoost原理

某种算法里的XGBoost这一存在,属于boosting算法当中的一种情况,boosting算法展现出这样的思索方式,即把众多的弱分类器进行整合,进而构建起一个强分类器,由于XGBoost属于一种提升树模型,所以它是把诸多的树模型予以整合,最终形成一个具备很强能力的分类器,而其中所运用到的树模型乃是CART回归树模型,讲述其原理之前,先对CART回归树展开一番讲解。

一、CART回归树

CART回归树假定树是二叉树,借助持续对特征展开分裂,举例来说,当前树结点依据第j个特征值予以分裂,把该特征值小于s的样本划分至左子树,将大于s的样本划分到右子树。

就CART回归树来讲,其本质上是于这个特征维度针对样本空间予以划分,然而这样的空间划分的优化属于一种NP难问题,所以,在决策树模型里是运用启发式方法去解决。典型的CART回归树所产生的目标函数是:

所以,在我们致力于求解最优的切分特征j之时,同时也在求解最优的切分点s,进而就转化为对一个目标函数的求解,就是这样 。

因此,我们只需对所有特征的全部切分点展开遍历,借此便可寻得最优的切分特征以及切分点。最终会由此获得一棵回归树。

二、XGBoost算法思想

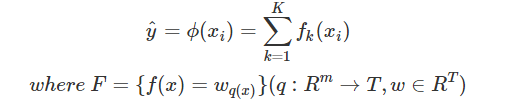

该算法思想是,不断地去添加树,持续地进行特征分裂从而生长一棵树,每次添加一棵树时,实际上是在学习一个全新函数,借此去拟合上次预测所产生的残差。待到我们训练完毕获取了k棵树,我们若要预测一个样本的分数,实则是依据这个样本的特征,在每棵树当中会落到与之对应的一个叶子节点,每个叶子节点都对应着一个分数,最后仅仅需要把每棵树所对应的分数加起来,这便是该样本的预测值。

注意,w_q(x)是叶子节点q的分数,f(x)是其中一棵回归树, 。

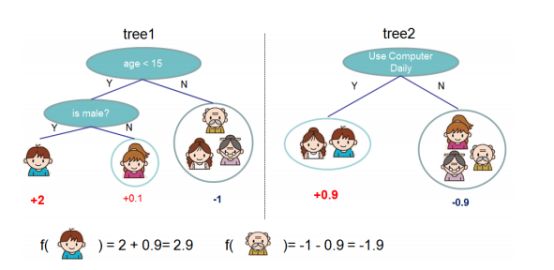

例如下图所示,训练得出了2棵决策树,小孩的预言得分便是两棵树里小孩所落入的节点的分数加起来。对于爷爷的预知得分也是这样 。

三、XGBoost原理

XGBoost目标函数定义为:

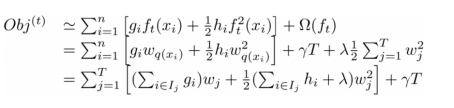

目标函数是由两部分给构成的,其中的第一部分,它的作用是去衡量预测分数与真实分数之间的差距,而另外一部分呢,它是正则化项。正则化项同样是包含着两部分的,这里面,T所表示的是叶子结点的个数,w所表示的是叶子节点的分数。γ能够对叶子结点的个数起到控制作用,λ能够控制叶子节点的分数不会变得过大,以此来防止出现过拟合的情况。

正如上面所讲,新长出来的树是用来拟合上一回预测所产生的残差的情形,也就是在生成了t棵树之后,预测获得的分数能够写成这样:

同时pg电子麻将胡了入口下载,可以将目标函数改写成:

清晰可见,紧接着我们所要做的便是寻觅一个f_t,使其能够将目标函数降至最低限度。XGBoost的思路乃是借助于它在f_t等于0这个特定位置的泰勒二阶展开式来对其予以近似处理。故而,目标函数经近似后呈现为:

其中g_i为一阶导数,h_i为二阶导数:

因前t减1棵树的预测分数跟y的残差对于目标函数的优化而言不存在影响,故能够直接将其去掉,进而简化目标函数为:

是把每个样本的损失函数值加起来得出上式的,我们清楚,每个样本最后终将落到一个叶子结点里,因而我们能够将处于同一个叶子结点的样本重新组合起来,过程如下所示:

那么,因着对上式予以改写,我们能够把目标函数变化成关乎叶子结点分数w而言的一个一元二次函数去呈现pg国际电子游戏app,如此一来,求解最优的w以及目标函数值这事就转变成颇为简易的情形了,径直动用顶点公式便能达成。所以,最优的w以及目标函数公式是。

四、分裂结点算法

于上述的推导里面,我们清楚了要是一棵树的结构已然确定,那么怎样去求得每一个叶子结点的分数。然而,我们尚未阐述怎样去确定树结构,也就是每次特征分裂时,怎么寻觅最佳特征,又怎么寻觅最佳分裂点。

前面提到过,依据空间切分来构建一棵决策树属于NP难问题,我们没办法遍历全部树结构,所以,XGBoost采用了与CART回归树相同的思路,凭借贪婪算法pg问鼎安卓下载,去遍历所有特征的各个特征划分点,不一样的是把上式目标函数值用作评价函数。具体做法就是分裂之后的目标函数值相较于单子叶子节点的目标函数的增益,并且为了限制树生长得过于深,还增设了一个阈值,只有当增益大于该阈值时才开展分裂。

这里,能够进行设置,树的最大深度,当样本权重的总和小于所设定的阈值之时,就停止生长,以此来防止出现过拟合的现象。

五、收缩现象以及列子采样 ,收缩现象,列子采样 。

XGBoost还给出了两种用以防止过拟合的办法:Shrinkage以及Column Subsampling。Shrinkage办法是于每次迭代之际,针对树的每个叶子结点的分数乘上一个缩减权重η,这能够让每一棵树的影响力不至于过大,从而给后续生成的树造就更大空间去优化模型。Column Subsampling类似于随机森林里选取部分特征来建树 。它能够被划分成两种,一种是依照层的方式进行随机采样,在针对同一层里的每个结点实施分裂以前,先随机挑选一部分特征,接着仅仅需要对这部分的特征展开遍历,以此来确定最为合适的分割点。另一种是随机挑选特征,也就是在建树以前随机选取其一部门特征而后分裂时就只对这些特征进行遍历。通常情形下前者的效果会更佳。

六、近似算法

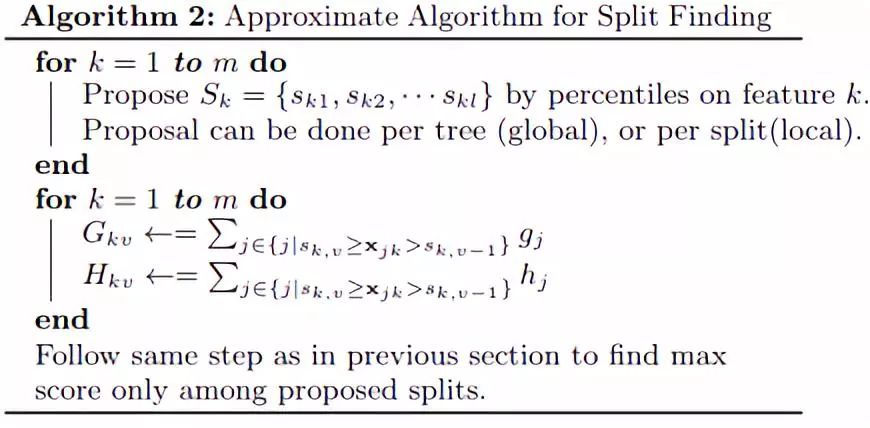

对于连续型特征值,在满足样本数量极大这一条件时,若该特征的取值过多,那么遍历全部取值会消耗诸多时间,并且极易出现过拟合情况。所以,XGBoost的思想是针对特征实施分桶操作,也就是要找出l个划分点,把处于相邻分位点之间的样本划分到同一个桶里。在遍历此特征时段,只需对各个分位点展开遍历,进而计算出最优划分。该流程在算法伪代码里,还能够分成两种,全局角度的近似为,于新生成一棵树以前,就针对各个特征去计算分位点,进而划分样本,此后在每每一次分裂的时候,均采用近似划分,而局部近似则是,在 specific 的某一次分裂节点的进程之中,采用近似算法。

七、针对稀疏数据的算法(缺失值处理)

若样本的第i个特征值出现缺失情况,无法借助该特征来开展划分作用时,XGBoost的思路是把该样本分别划分至左结点以及右结点,随后计算其增益,哪一边的增益大就将样本划分到哪一边。

八、XGBoost的优点

能够成为机器学习领域里的大杀器,在数据科学竞赛以及工业界被广泛运用,XGBoost存在着诸多优点,这就是其原因:

防备过拟合,会运用好多方式,像正则化项呢,还有Shrinkage再加上 Column Subsampling等这些 。

2. 目标函数优化利用了损失函数关于待求函数的二阶导数

具备支持并行化的特性,此为XGBoost的突出亮点,虽说树与树之间呈现串行关系,然而同层级节点能够并行操作。仅就某个特定节点而言,在该节点内部挑选最佳分裂点,对于候选分裂点计算增益时采用多线程并行方式开展,以确保实现训练速度快的效果。

4.添加了对稀疏数据的处理。

5.作交叉验证,搞early stop,在预测结果已然挺好之际能够提前停歇去建树,从而加快训练的速度。

可以设置样本权重,这个权重体现在一阶导数g上,还体现在二阶导数h上,通过调整这个权重能够更加关注某些样本。

鲁ICP备18019460号-4

鲁ICP备18019460号-4

我要评论